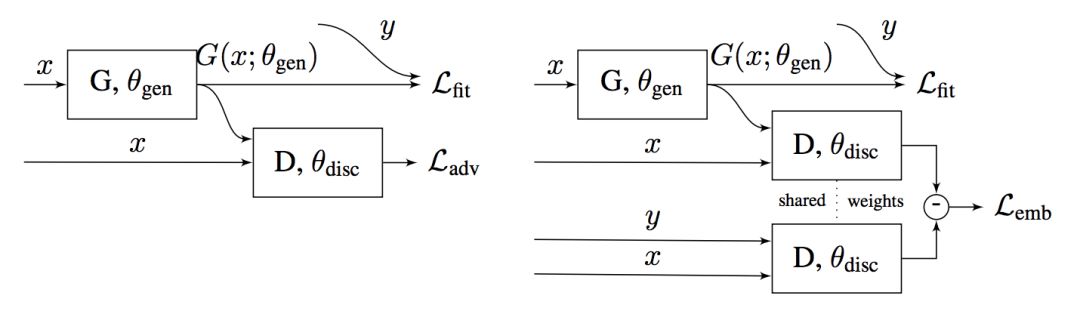

EL-GAN: Embedding Loss Driven Generative Adversarial Networks for Lane Detection

TuSimple lane de原由网tection challenge:检测车道线的比赛http://benchmark.tusimple.ai/#/t/1/leaderboard

GAN思路就是加了一个EmbeddingLoss:

Learning to Decompose and Disentangle RepresentationXVVnZpIQwrs for Video Prediction

Feifei Li

视频预测的隐变量分成两部分:

1. Context Embedding:这个Scene的构成元素(如球)

2. Pose Embedding: 这个Scene的构成元素是如何布局的(如球的移动,位置)

然后PoseEmbedding时间上用RNN建模,而ContextEmbedding不变,整体是一个变种的VAE。

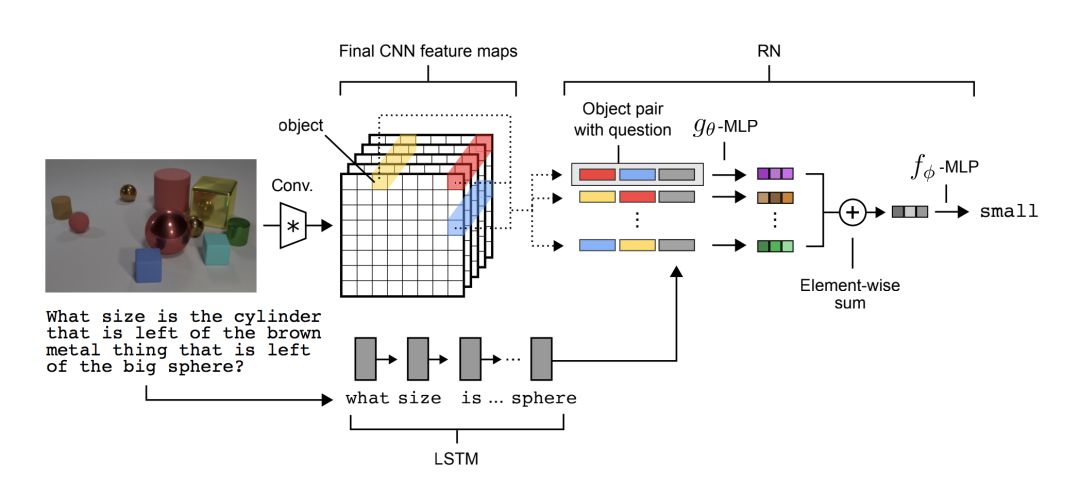

A simplwww.58yuanyou.come neural network module for relational reasoning + Relational Deep Reinforcement Learning

关于原由网Relational Reasoning:

CNN feature map的每一个2d位置作为一个object,两两之间通过g网络得出表示,表示的信息的每一维度蕴含着问题和关系事实的对应,这些信息再加起来通过f网络完成推理得到答案。

应用到Planning:

对于一个BoxWorld,有一个正确的移动位置序列,Agent需要找到这个移动序列。采取Relational的方式去plan:分析整个局面(各个位置移动的先后关系),得到action。

Automatic formation of the structure of abstract machines in hierarchical reinforcement learning with state clustering

考虑一个自动机,每一个状态对应一种行为模式。作者提出从0开始,自动通过分裂状态,连边,加转移条件来形成自动机的结构。每一种hiddenstate对应一个自动机。

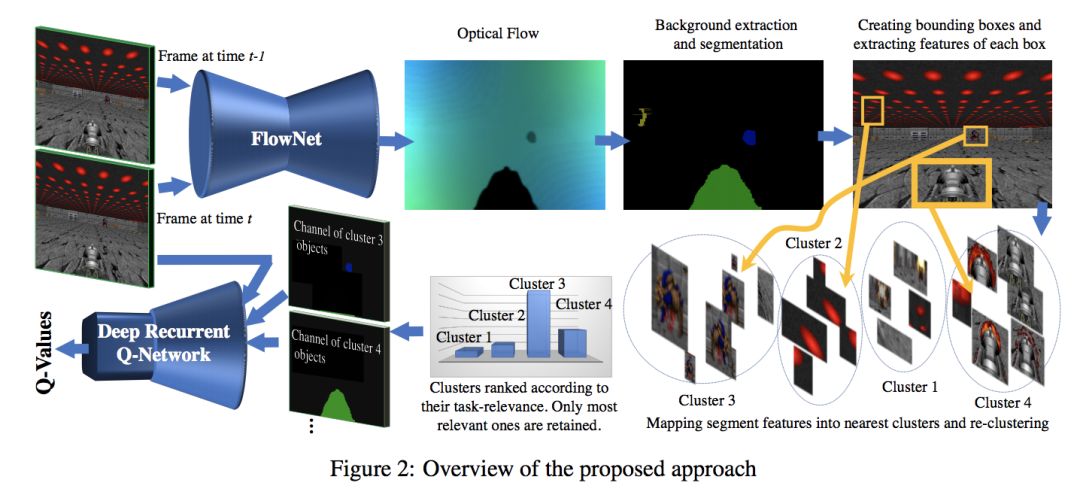

Task-Relevant Object Discovery and Categorization for Playing First-person Shooter Games

使用光流(Optical Flow),来直接提取出Segmentation(不用label训练)

然后将这些Segmentation用HOG feature聚类,聚类得到的比如怪物,主人公,墙都分开了。

再分别将这些这些分离的元素送给QLearning进行决策。

Self-Imitation Learning

SIL,直接利用自己已有的好轨迹进行模仿。

个人觉得和HER的能达到的效果是一致的。

Learning P//www.58yuanyou.comolicy Representations in Multiagent Systems

imitation learning来学出policy representations,然后将3种Embedding(最小化 最大化 和模仿)用于多Agent的环境下,使用Policy Embedding来交流。

心得-思考总结-反省: 今天效率较高,看了不少论文,但晚上写代码思路不清晰

明日计划: 1. 写完Candy(Carla 的 VAE+ImitationLearning)代码

公司招聘请公众号回复招聘。